Avec ImageNet Roulette, deux chercheurs soulignent des problèmes systémiques entourant le futur de la technologie. […] Jusqu’au 24 février 2020 à la Fondation Prada de Milan, l’exposition photo « Training Humans » a cependant pour vocation de questionner ces progrès grandissants, et notamment les intelligences artificielles, à travers deux axes : « La façon dont les humains sont représentés, interprétés et codifiés selon les données d’entraînement, et comment les systèmes technologiques cultivent, étiquettent et utilisent ces données.« […]

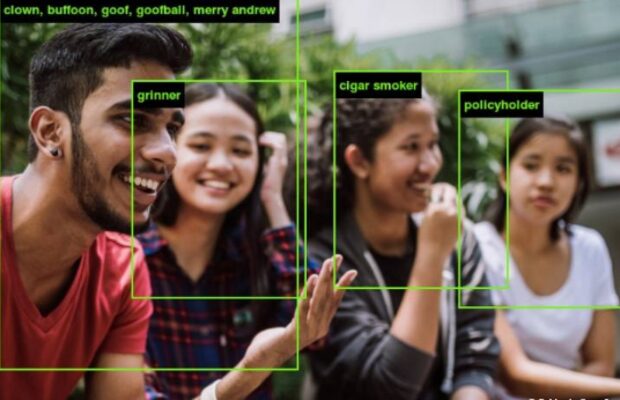

Si le projet semble bon enfant au départ – et qu’une certaine excitation peut même être ressentie à l’idée de découvrir comment un ordinateur va vous définir –, les résultats sont loin d’une objectivité binaire et sont gonflés de préjugés. Après quelques essais, on se rend bien vite compte que l’algorithme est, entre autres, raciste.

En effet, ce ne semble pas être une coïncidence que les personnes aux peaux claires se voient affublées de noms et de caractéristiques mélioratives (« psycholinguiste », »millionnaire », « sociologue », « clinicien », « non-fumeuse », etc.) tandis que les individus aux peaux foncées sont tout de go caractérisés de façon péjorative (« orphelin », « personne de classe inférieure ») ou uniquement par rapport à leur couleur de peau (« femme noire », « noir africain »). […]

En savoir plus sur Notre Quotidien

Subscribe to get the latest posts sent to your email.